AIにその手があったか!DeepSeekの革新性を研究者が論文解説する

DeepSeekという新しいAIが話題です。DeepSeek社が発表した新しい言語モデル「DeepSeek-R1」の開発手法は、既存の常識を打ち破る革新的なアプローチです。AIコミュニティーだけでなく、経済ニュースなどでも報道されるほどです。

著者は普段、生命医学のためのAIを研究している開発者ですが、DeepSeekに関する論文を読みながらそのブレイクスルーを読み解いていきます。リープリーパーでは、AIの最新情報に関する記事を随時投稿しているので、併せてお読みください。

世界を驚かせたDeepSeek

2025年1月、DeepSeekの躍進が世界的な反響を呼び起こしました。同社のAIモデルが、米OpenAIなどの大手企業と比べてはるかに少ないGPUチップで、同等の性能を実現したことが明らかになったのです。この衝撃的なニュースは、NVIDIAの株価を一日で17%も下落させるほどの影響がありました。

では、なぜDeepSeekは少ないリソースで大きな成果を上げることができたのか?その鍵となる技術的ブレイクスルーを見ていきましょう。

DeepSeekが公開した研究論文

DeepSeekが公開した研究論文は以下です。この研究は、限られたコンピューティングリソースでも高性能なAIモデルを開発できることを実証し、AI開発の新しい可能性を示しました。OpenAIの既存のGPT-4と互角の性能を、はるかに少ない計算リソースで実現したその手法論が話題になっています。

DeepSeek-R1-Zeroモデルの開発を経て、これを発展させたDeepSeek-R1モデルを作る理論的な取り組みについて記述されています。

▼[2501.12948] DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning

https://arxiv.org/abs/2501.12948

革新的アプローチ1 – 教師なし強化学習への挑戦

DeepSeekの第一の革新は、「DeepSeek-R1-Zero」の開発です。このモデルは、人間が作った教師データを一切使わず、純粋な「強化学習」だけでAIを訓練するという画期的な取り組みでした。

強化学習とは?

ここで少し、強化学習について説明しましょう。強化学習は、人工知能が「試行錯誤を通じて学習する」方法です。例えば、以下のような例があります。

- AIが何か行動を取る

- その行動の結果に対して報酬(または罰)が与えられる

- AIは報酬が最大になるような行動を学習していく

身近な例で言えば、ゲームのテトリスをプレイするAIを考えてみましょう。ブロックを積み上げて列を消すと点数が入り、逆に積みすぎてゲームオーバーになると罰が与えられます。AIはこの報酬と罰を通じて、より良い積み方を学んでいくのです。

従来の言語モデル開発における強化学習の課題

従来の言語モデルの開発では、強化学習を適用する際に大きな課題がありました。まず、モデルの出力の良し悪しを判断するための「報酬モデル」を作る必要があります。

このために、人間が「良い回答」と「悪い回答」の大量のペアを作成し、それを基に別の大規模なニューラルネットワークを訓練する必要がありました。人間を大量に雇って、大量のラベル付けをして教師データを作るのが、OpenAIなどが元々提唱していた手法です。データを作るのにも、手間もコストも掛かるのです。

さらに、各行動の価値を推定するための「価値モデル」も必要でした。このモデルも、言語モデル本体と同じくらいの規模が必要となるため、実質的に計算コストが2倍になってしまいます。

論文の著者らによるブレイクスルー:コスト削減の実現

DeepSeekの革新性は、これら2つのコストを劇的に削減した点にあります!!

「報酬モデル」について、彼らは人手によるデータ作成と追加のニューラルネットワークを完全に不要にしました。代わりに、数学の問題の正誤判定のような、計算機で自動的に評価できる「ルールベースの報酬」を採用したのです。これは一見単純な変更に見えますが、実は非常に賢明な選択でした。

なぜなら、数学やプログラミングのような問題では、答えが合っているかどうかは機械的に判定可能だからです。

DeepSeek-R1-Zeroの驚くべき成果

このアプローチで作られたDeepSeek-R1-Zeroは、数学のAIME 2024テストで71.0%という高スコアを達成。複数回の試行を組み合わせると、86.7%まで性能が向上し、OpenAIの最新モデルと互角の結果を示しました。

特筆すべきは、このモデルが問題解決の過程で「Aha Moment(ひらめきの瞬間)」とも呼べる振る舞いを見せたことです。問題を解く途中で「待て、これは違う方向かもしれない!」と自らの推論を見直し、新しいアプローチを試みるような高度な問題解決能力を獲得したのです。

革新的アプローチ2 – GPROという新しい学習方法

強化学習における報酬と価値の違い

強化学習では「報酬」と「価値」という2つの概念が重要になります。これを具体例で説明しましょう。

チェスの場合、「相手の駒を取る」という行動に対して即座に得られるのが「報酬」です。一方「価値」は、その行動がゲームの勝利にどれだけ貢献するかという長期的な評価です。例えば、クイーンを失うリスクを冒してポーンを取る行動は、即時の報酬は高くても価値は低いかもしれません。

言語モデルの場合、各単語を出力する行動に対して報酬を与えることはできますが、その行動が最終的な回答の質にどう影響するかを評価する、「価値」の推定が必要になります。

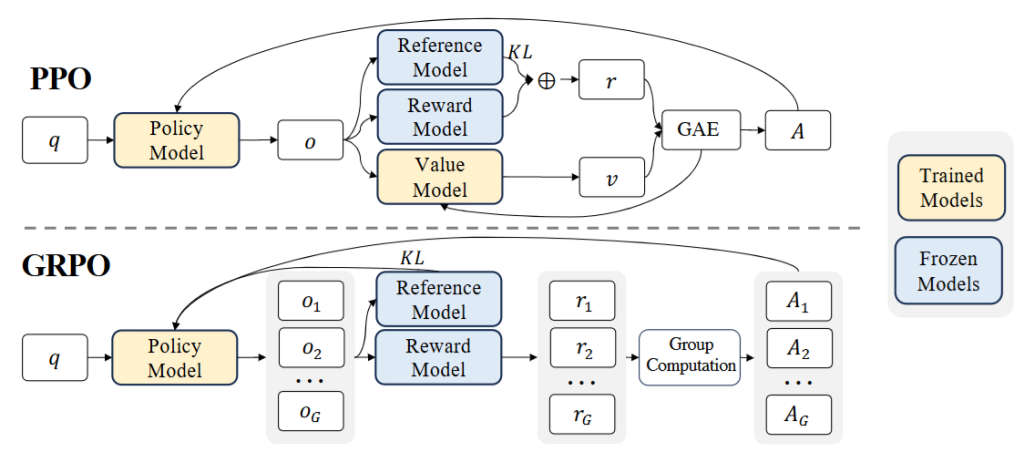

従来は、この価値を推定するために巨大な価値モデルが必要でした。それが、著者らによる理論の提唱論文の図でいうところの、Value Modelが不要になるというのです。

出典:[2402.03300] DeepSeekMath: Pushing the Limits of Mathematical Reasoning in Open Language Models

https://arxiv.org/abs/2402.03300

GPROによる革新:価値の相対評価

DeepSeekが提案したGPRO(Group Relative Policy Optimization)は、この価値推定を賢く回避します。従来手法のPPO(Proximal Policy Optimization)では、個々の行動の絶対的な価値を推定する必要がありましたが、GPROは以下のように動作します。

1. 同じ問題に対して複数の回答を生成

例:「2+2は?」という問題に対して

- 回答A:「まず2と2を足すと4になります」

- 回答B:「2に2を加えることで答えは4です」

- 回答C:「2足す2で4という結果が得られます」

2. それぞれの回答の報酬を計算

- すべての回答が正解なら、同じ報酬を獲得

3. グループ内での相対比較

- 各回答の報酬を、グループ全体の平均報酬と比較

- 平均より良い回答の生成確率を上げる

- 平均より悪い回答の生成確率を下げる

この方法により、価値モデルという追加のニューラルネットワークが不要になり、複数の回答の「相対的な」良さだけで学習が可能です。計算コストを大幅に削減しながら、効果的な学習を実現できるようになります。

完成形としてのDeepSeek-R1

しかし、DeepSeek-R1-Zeroには以下のような課題もありました。

- 読みにくい出力(言語の混在など)

- 学習の初期段階での不安定さ

- 一般的なタスクへの対応の弱さ

これらを解決するため、以下のような改良が加えられました。

コールドスタート問題への対処

強化学習の初期段階での不安定さを解消するため、少量の教師データ(Chain-of-Thoughtデータ)で事前に訓練したことで、以下の改善が実現しました。

- より安定した学習の実現

- 読みやすい出力形式の獲得

- 基本的な推論能力の確立

言語一貫性の実現

また、出力の質を向上させるため、「言語一貫性報酬」という新しい報酬を導入。これにより、一つの言語で一貫した回答を生成できるようになりました。

反復的な学習サイクル

最終的なDeepSeek-R1は、以下のサイクルを経て完成しました。

- 基本的なファインチューニング

- 強化学習による能力向上

- 生成された回答からの新しい学習データ収集

- さらなるファインチューニング

- 最終的な強化学習

小規模モデルへの技術移転 – 効率的な推論能力の民主化

なぜ小規模モデルが必要か

DeepSeek-R1は671Bという膨大なパラメーターを持つモデルです。このサイズのモデルは、以下のような制限があります。

- 一般的な家庭用PCでは動作が困難

- 大規模なGPUリソースが必要

- 計算コストが高く、広く利用することが難しい

しかし、DeepSeekの目標は「効率的な推論能力を持つAIを、より多くの人々が利用できるようにすること」でした。そのために、より小規模なモデルでも同様の推論能力を実現する方法の研究が必要でした。

蒸留による知識移転の実践

研究チームは、以下のような段階的なアプローチを取りました。

1. 訓練データの準備

- DeepSeek-R1から約80万の高品質な訓練サンプルを生成

- 推論に関する60万サンプル

- 一般的なタスクに関する20万サンプル

2. 複数のモデルサイズでの検証

- Qwen2.5シリーズ(1.5B, 7B, 14B, 32B)

- Llamaシリーズ(8B, 70B)

- で実験を実施

特に注目すべきは、7B程度の比較的小さなモデルでも、AIME 2024で55.5%という高いスコアを達成し、GPT-4oやClaude-3.5-Sonnetを上回る性能を示したことです。これは、家庭用PCでも動作可能なサイズのモデルで、高度な推論能力の実現が可能であることを意味します。

この成果は、AIの民主化という観点から非常に重要です。高度な推論能力を持つAIを、より多くの研究者や開発者が利用できるようになることで、AIの発展がさらに加速することが期待されます。

この研究が示す、AI開発・利用の民主化が加速する未来

この研究からは、いくつかの重要な示唆が得られます。

- 強化学習による自律的な能力獲得の可能性

- シンプルな報酬設計の有効性

- 大規模モデルで獲得した能力の効率的な移転方法

特に重要なのは、AIが「試行錯誤を通じて自律的に学習する」という方向性を示したことです。これによって、より効率的で柔軟なAI開発の新しい可能性が開かれました。DeepSeekのこの研究は、AI開発に新しい地平を開きました。特に、シンプルな報酬設計で複雑な能力を獲得できることを示した点は、今後のAI開発に大きな影響を与えるでしょう。

また、開発されたモデルがオープンソースなことも重要です。Hugging Faceなどを介して、自分たちのローカルサーバーやPCでも利用できる環境が開かれているということです。我々の研究室にもGPUを搭載したサーバーがあるので、そういう環境なら普通にWebアプリではないバージョンでモデルを試せます。

前述のNVIDIA株急落が示すように、DeepSeekの登場でGPUが要らなくなるんじゃないか?みたいな言論もあります。しかし、提案手法をGPUでスケールさせてより賢いAIを使うという方法に普通に進むと思うので、楽観的に捉えておいていいと思います。

あと、強化学習がどんどん発展して、その能力が証明されていることにも注目しています。大規模言語モデル以外の、例えばゲノム解析などのバイオインフォマティクス(生命科学と情報科学の融合分野)に、強化学習の技術を活用するような研究がしたいなと思いました。筆者は深層学習ベースの開発をしているのですが、強化学習はまだ触ったことがありません。でも、普通に強化学習してみたくないですか!?自分の手で。

今後も、技術の発展を追っていきたいと思います!

参考文献

- Shao, Zhihong, et al. “Deepseekmath: Pushing the limits of mathematical reasoning in open language models.” arXiv preprint arXiv:2402.03300 (2024).

- Guo, Daya, et al. “DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning.” arXiv preprint arXiv:2501.12948 (2025).

- DeepSeek-R1の論文読んだ?【勉強になるよ】https://zenn.dev/asap/articles/34237ad87f8511

- 「DeepSeek」躍進受け、NVIDIAがコメント 自社チップの需要拡大を示唆 株価は17%急落

https://www.itmedia.co.jp/aiplus/articles/2501/28/news127.html