トークン拡大と価格暴落!2024年のAIとLLMの発展を振り返る

AIの急速な発展に伴って、大規模言語モデル(LLM)は、言語理解と生成能力の向上を推進する重要な力となっています。2024年は年末まで、学術研究や商業応用の両方の分野において大規模言語モデルで多くの出来事が起こり、顕著な進歩を遂げました。以下は、過去12か月間の大規模言語モデル分野に関する振り返りです。

大規模言語モデル(LLM)の概要

大規模言語モデルは、大量のデータの分析を通じて、人間のようなテキストを生成および理解することを目的としたAIモデルです。これらの基盤モデルは、深層学習技術に基づいていて、通常、多くの層と大量のパラメーターを持つニューラルネットワークが含まれています。これにより、それらがトレーニングデータの複雑なパターンを捉えることができます。

大規模言語モデルの主な目標は、自然言語の構造や文法、意味、コンテキストを理解することです。それらに適した応答を生成したり、関連する情報で与えられたテキストを出力することが目標です。

これらのモデルは、書籍や記事、Webサイト、その他のテキストコンテンツを含む、多様なテキストデータソースでトレーニングされています。これにより、幅広いトピックに関する応答を生成できるようになります。

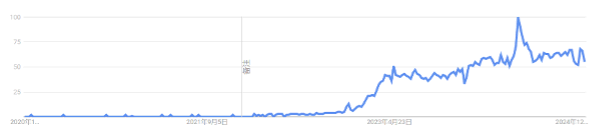

2022年11月末の ChatGPT のリリース以降、大規模言語モデルへの関心が高まり続けています。

GPT-4の壁が完全に崩壊して群雄割拠に

OpenAIは2023年の一年間、最高のモデルであるChatGPTで圧倒的な地位を占めてきました。他のAI関連組織からは、ChatGPTを上回る製品は生まれていませんでした。しかし、この12か月でその状況は完全に変わりました。

現在、複数の組織が2023年3月のオリジナルGPT-4(GPT-4-0314)を上回るモデルを持っています。最初の製品は、2024年2月にリリースされたGoogleのGemini 1.5 Pro[1]でした。Gemini 1.5 Proは、GPT-4レベルの出力を生成するだけでなく、この分野にいくつかの新機能を導入しました。最も注目すべきは、100万(この後に200万まで伸びた)トークンの入力コンテキストの長さと、動画を入力し分析する能力です。

▼Chatbot Arena (formerly LMSYS): Free AI Chat to Compare & Test Best AI Chatbots

https://lmarena.ai/?leaderboard

Gemini 1.5 Proは、2024年の重要なテーマの一つである長いコンテキストへの対応を示しました。長い文章が入力できるようになったことで、LLMが解決できる問題の範囲が大幅に拡張されました。今では、一冊の本を丸ごと入力してその内容に関する質問もできます。

さらに重要なのは、大量のサンプルコードを入力して、モデルにコーディングの問題を解決してもらうことも可能になりました。昨年、大多数のモデルは4,096または8,192トークンの入力を受け入れていました。今日、どのようなサービスでも10万以上のトークンモデルを持っており、GoogleのGeminiシリーズは最大200万トークンをサポートしています。

今、前述のChatbot Arenaのランキングを見てみると、GPT-4-0314は約70位に落ちています。スコアが高いモデルを持つのは、以下の18の組織です。GPT-4を打ち負かすモデルを訓練することは、2023年には大きな出来事でしたが、2024年にはこの成果は特に注目に値するものではありませんでした。

- OpenAI

- Alibaba

- Anthropic

- Meta

- Reka AI

- 01 AI

- Amazon

- Cohere

- DeepSeek

- Nvidia

- Mistral

- NexusFlow

- Zhipu AI

- xAI

- AI21 Labs

- Princeton

- Tencent

競争と効率の向上によるLLM価格の暴落

AIの急速な機能強化と競合との対立の結果、大規模言語モデルを利用するコストは下がり続けています。

2023年12月、OpenAIはGPT-4に対して100万入力トークンあたり30ドルでした。当時、新しくリリースされたGPT-4 Turboは同10ドル、GPT-3.5 Turboは同1ドルでした。

現在、OpenAIの最も高価なモデルo1を利用するライセンス料は同30ドルです[2]。GPT-4oの価格は同2.50ドル(GPT-4より12倍安い)、GPT-4o miniの価格は同0.15ドル—これはほぼGPT-3.5の7倍安く、しかも能力は大幅に向上しています。

他社モデルの料金はさらに低く、Anthropic Claude 3 Haikuは100トークンあたり0.25ドルです。Google Gemini 1.5 Flashは同0.07ドルで、Gemini 1.5 Flash 8Bは同0.04ドル—これは昨年のGPT-3.5 Turboより27倍安いです。

| モデル | 入力 | 出力 |

| Gemini 1.5 Flash-8B | 0.04 | 0.15 |

| Gemini 1.5 Flash | 0.07 | 0.30 |

| GPT-4o Mini | 0.15 | 0.60 |

| Claude 3 Haiku | 0.25 | 1.25 |

| Claude 3.5 Haiku | 1.00 | 5.00 |

| GPT-4o | 2.50 | 10.00 |

| Claude 3.5 Sonnet | 3.00 | 15.00 |

| Claude 3 Opus | 15.00 | 75.00 |

各大規模言語モデルの価格

参考:LLM Pricing Calculator – LLM Price Check

https://llmpricecheck.com/calculator/

価格が低下し続けている理由は、競争の激化と効率の向上という2つの要因です。

ここで、一つの例を示します。2024年10月にリリースされたGoogle Gemini 1.5 Flash 8Bを使って、10,000枚の写真の短い説明(キャプション)を生成するのにかかるコストはどのくらいでしょうか?各写真には、400個の入力トークンと約100個の出力トークンが必要だと仮定します。

- 400 * 10,000 = 4,000,000 入力トークン

4,000,000 * $0.04/100万 = $0.16 - 100 * 10,000 = 1,000,000 出力トークン

1,000,000 * $0.15/100万 = $0.15

10,000枚の画像を処理する合計コストは、わずか0.31ドル(2025年1月20日時点の為替レートで約48円)。これは驚くべき安さです。

年末に突如登場した、驚異的な最安モデル

機能強化と価格低下は止まりません。2024年12月、「中国で訓練された最良の利用可能な大規模言語モデルのコストが600万ドル未満」という大ニュースが発表されました。それが、クリスマスにHugging Face(AIのモデルやデータを共有し、利用するオープンソース・プラットフォーム)でリリースされたDeepSeek v3[3]でした。

DeepSeek v3は、巨大なパラメーターモデル(6,850億)で、現在利用可能な最大のオープン・ライセンスモデルの1つであり、MetaのLlamaシリーズの中で最大のLlama 3.1(405億パラメーター)を大きく上回ります。現在、前述のChatbot Arenaのランキングで7位にランクされています。

DeepSeek v3の特に印象的な点は、訓練コストです。このモデルはH800 GPUで278万8,000時間訓練され、推定コストは557万6,000ドルです。Llama 3.1 405BのGPU時間は3,084万時間で、DeepSeek v3の11倍です。ただし、DeepSeek v3モデルのベンチマークはやや劣っています。

大規模言語モデルには批評が必要

大規模言語モデルの台頭からすでに2年以上が経過しましたが、何か記事や意見を発表すること—たとえそれが「大規模言語モデルは有用である」と暗示するだけでも、いつも大きな議論を引き起こします。正しく冷静な議論だけでなく、誇大広告も盛んになり、虚偽の宣伝や誤情報が氾濫しているからです。

最近、中国企業が開発した新しいAIモデルであるDeepSeekが話題になっています。先日は、アメリカのApp StoreランキングでChatGPTを抜いて1位となったほど。このモデルについては、現在多くのポジティブな視点とネガティブな視点がありますが、オープンソースなので、これを土台として研究者がより強力なモデルを開発できます。

大規模言語モデルは確かに批判に値する存在であり、その背景は多岐にわたります—訓練データの倫理観の欠如や信頼性の不足、悪用の可能性、人々の職業への潜在的影響などです。衝撃的なAIの登場で、2025年の発展のスピードはもはや2024年の比ではないと予想されます。これからも、問題を軽減する方法を見つけ、責任を持って使用する方法を学ぶ手助けをし、消極的な対応ではなく積極的な応用を進める必要があるでしょう。

参考文献

[1] Gemini Pro – Google DeepMind

[2] ChatGPT | OpenAI Help Center

[3] deepseek-ai/DeepSeek-V3-Base · Hugging Face